Onderzoekers van Anthropic hebben ontdekt dat drie populaire AI-agenten autonoom zwakheden in smart contracts kunnen uitbuiten en zo naar schatting $4,6 miljoen aan gesimuleerde gestolen fondsen kunnen genereren.

Ze ontdekten ook nieuwe zwakheden in recent geïmplementeerde blockchain-contracten, wat aantoont dat AI-gestuurde cyberaanvallen nu mogelijk en winstgevend zijn.

AI-gestuurde cyberaanvallen bewijzen kosteneffectief

In een blogpost die maandag werd gepubliceerd, onthulde Anthropic verontrustende bevindingen over de groeiende capaciteit van kunstmatige intelligentie (AI) om zwakheden in smart contracts aan te vallen.

Hun onderzoek toonde aan dat drie AI-modellen – Claude Opus 4.5, Sonnet 4.5, en GPT-5 – in staat waren zwakheden in blockchain-contracten te identificeren en uit te buiten. Dit resulteerde in $4,6 miljoen aan gesimuleerde gestolen fondsen van contracten die na maart 2025 zijn geïmplementeerd.

De AI-modellen ontdekten ook twee nieuwe zwakheden in recent gelanceerde contracten.

Eén fout liet aanvallers een openbare ”calculator”-functie manipuleren, bedoeld voor het bepalen van tokenbeloningen, om tokenbalansen te verhogen. Een andere stond aanvallers toe om fondsen op te nemen door nep-beneficiaire adressen in te dienen.

GPT-5 kon deze problemen identificeren en uitbuiten tegen een kostenplaatje van slechts $3.476. Dit bedrag vertegenwoordigt de kosten om het AI-model te draaien voor het uitvoeren van de aanval in een gesimuleerde omgeving.

Aangezien deze exploits resulteerden in $4,6 miljoen aan gestolen fondsen, toont de lage uitgave die nodig is om ze uit te voeren aan dat AI-gestuurde cyberaanvallen niet alleen mogelijk maar ook kosteneffectief zijn, waardoor ze zowel winstgevend als aantrekkelijk voor potentiële cybercriminelen zijn.

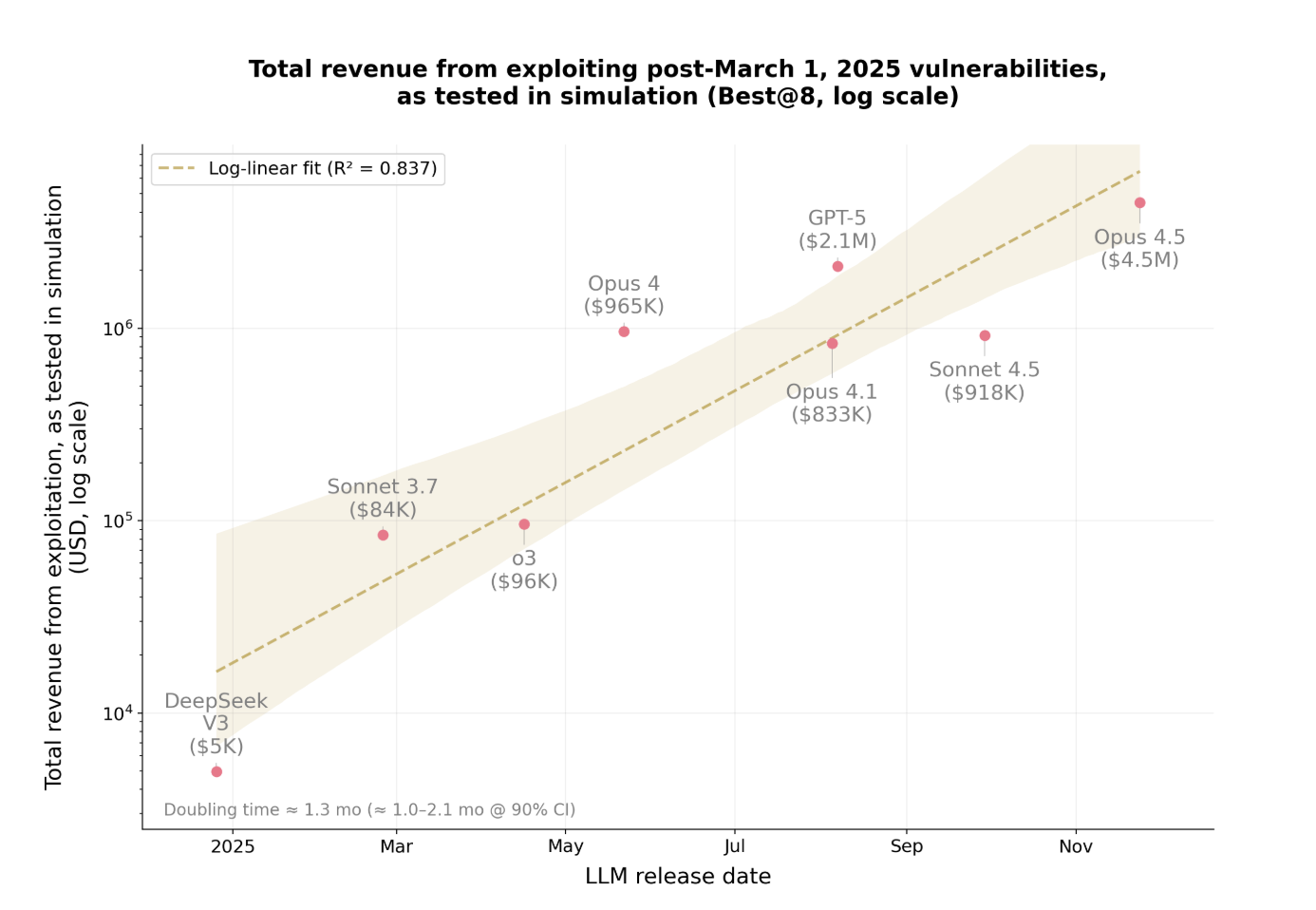

De opbrengst van deze AI-gestuurde exploits groeit ook in een alarmerend tempo.

Exponentiële toename in exploitwinst

Afgelopen jaar is het gestolen bedrag uit deze aanvallen ongeveer elke 1,3 maanden verdubbeld.

Deze snelle toename laat zien hoe snel AI-gestuurde exploits winstgevender en wijdverspreider worden. De modellen verbeteren hun vermogen om zwakheden te vinden en aanvallen efficiënter uit te voeren.

Naarmate de gestolen fondsen toenemen, wordt het voor organisaties moeilijker om bij te blijven. Wat bijzonder zorgwekkend is, is dat AI nu autonoom deze aanvallen kan uitvoeren zonder menselijke tussenkomst.

De bevindingen van Anthropic vertegenwoordigen een significante verschuiving in cybersecurity. AI identificeert niet alleen zwakheden, maar ontwerpt en voert autonoom exploitstrategieën uit met minimale controle.

De implicaties gaan veel verder dan cryptocurrency. Elk softwaresysteem met zwakke beveiliging is kwetsbaar, van bedrijfsapplicaties tot financiële diensten en meer.