De Groep van Zeven (G7) industriële naties staan op het punt om een vrijwillige ‘gedragscode’ op te stellen voor bedrijven die innoveren op het gebied van geavanceerde kunstmatige intelligentie (AI)-systemen. Dit initiatief, dat voortkomt uit het “Hiroshima AI-proces”, is bedoeld om mogelijk misbruik en risico’s van deze transformatieve technologie aan te pakken.

De G7, bestaande uit Canada, Frankrijk, Duitsland, Italië, Japan, Groot-Brittannië en de Verenigde Staten, samen met de Europese Unie, hebben dit proces geïnitieerd om een precedent te scheppen voor AI-governance.

G7-landen stellen wereldwijde AI-gedragscode op

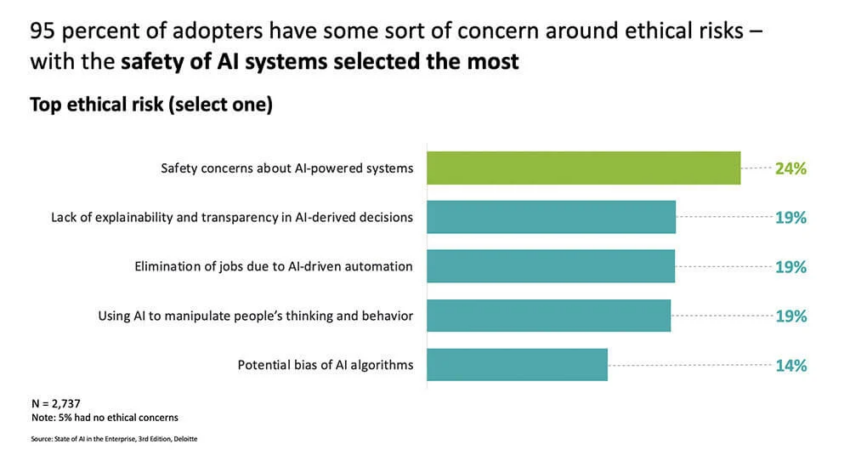

Te midden van toenemende zorgen over privacy en veiligheidsrisico’s is de 11-puntencode een baken van hoop. Volgens een document van de G7 is de gedragscode,

“Het doel is om wereldwijd veilige, beveiligde en betrouwbare AI te bevorderen en zal vrijwillige richtlijnen bieden voor acties door organisaties die de meest geavanceerde AI-systemen ontwikkelen.”

De code moedigt bedrijven aan om risico’s te identificeren, te evalueren en te beperken gedurende de gehele levenscyclus van AI. Verder beveelt de code aan om openbare rapporten te publiceren over AI-mogelijkheden, beperkingen en gebruik, met de nadruk op robuuste security controles.

Lees meer: De 6 Hottest Artificial Intelligence (AI) Jobs in 2023

Vera Jourova, hoofd digitale zaken van de Europese Commissie, verklaarde tijdens een forum over internetgovernance,

“Een gedragscode was een sterke basis om de veiligheid te garanderen en zou een brugfunctie vervullen totdat er regelgeving is.”

OpenAI sluit zich aan bij de zaak

OpenAI, het moederbedrijf van ChatGPT, heeft ook een Preparedness-team gevormd om de risico’s van AI-modellen te beheren. Onder leiding van Aleksander Madry zal het team zich bezighouden met risico’s zoals geïndividualiseerde overtuigingskracht, cyberbeveiligingsrisico’s en de verspreiding van desinformatie.

Deze stap is OpenAI’s bijdrage aan de aankomende wereldwijde AI-top in het Verenigd Koninkrijk en is een echo van de wereldwijde roep om veiligheid en transparantie in AI-ontwikkeling.

De Britse overheid definieert Frontier AI als,

“Highly capable general-purpose AI models that can perform a wide variety of tasks and match or exceed the capabilities present in today’s most advanced models.”

Het Paraatheidsteam van OpenAI zal zich richten op het beheersen van de risico’s, waardoor de behoefte aan een wereldwijde AI-gedragscode nog duidelijker wordt.

Nu AI zich blijft ontwikkelen, zijn de proactieve houding van de G7 en de inzet van OpenAI voor risicobeperking tijdige reacties. De vrijwillige gedragscode en de oprichting van een speciaal team voor paraatheid zijn sterke stappen om de kracht van AI op verantwoorde wijze te benutten. Het doel is om ervoor te zorgen dat de voordelen worden gemaximaliseerd terwijl potentiële risico’s effectief worden beheerd.

Disclaimer

In overeenstemming met de richtlijnen van het Trust Project zet BeInCrypto zich in voor onbevooroordeelde, transparante berichtgeving. Dit nieuwsartikel is bedoeld om accurate, actuele informatie te verstrekken. Lezers wordt echter aangeraden om feiten onafhankelijk te verifiëren en een professional te raadplegen voordat ze beslissingen nemen op basis van deze inhoud.

Dit artikel is in eerste instantie samengesteld door een geavanceerde AI, ontworpen om informatie uit een breed scala aan bronnen te extraheren, analyseren en organiseren. De AI werkt zonder persoonlijke overtuigingen, emoties of vooroordelen en levert data-gerichte inhoud. Om de relevantie, nauwkeurigheid en naleving van de redactionele standaarden van BeInCrypto te garanderen, heeft een menselijke redacteur het artikel zorgvuldig beoordeeld, geredigeerd en goedgekeurd voor publicatie.

Disclaimer

Alle informatie op onze website wordt te goeder trouw en uitsluitend voor algemene informatiedoeleinden gepubliceerd. Elke actie die de lezer onderneemt op basis van de informatie op onze website is strikt op eigen risico.